یک کاربر آرستکنیکا گزارش داد که ChatGPT گفتگوهای خصوصی حاوی اطلاعات محرمانه ورود و جزئیات شخصی کاربران بیارتباط را به بیرون درز میدهد.

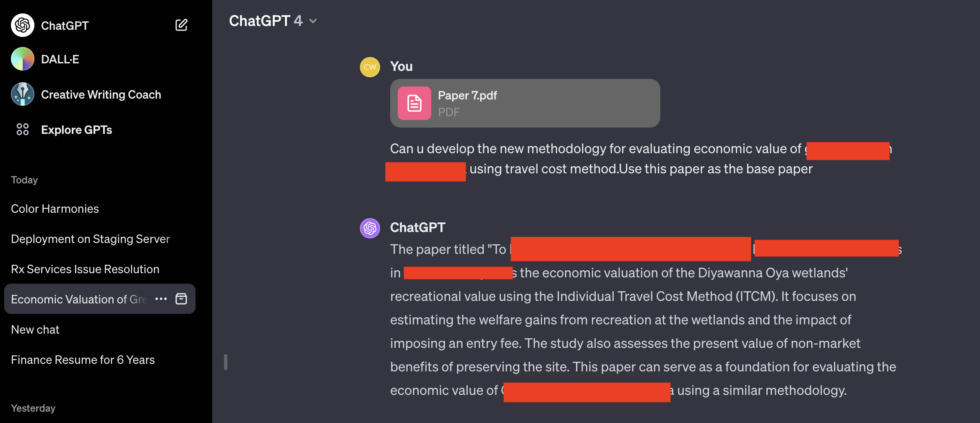

تصاویری که این کاربر در روز دوشنبه ارسال کرد، نشان میدهد که ChatGPT گفتگوهای خصوصی شامل نامهای کاربری، گذرواژهها و سایر اطلاعات شخصی مربوط به کاربران غیرمرتبط را فاش میکند.

دو مورد از هفت تصویر ارسالی بهویژه نگرانکننده بود. هر دو تصویر شامل چندین جفت نام کاربری و گذرواژه بودند که به نظر میرسید به یک سیستم پشتیبانی فنی مرتبط با کارمندان یک درگاه آنلاین تجویز دارو متصل باشند. بهنظر میرسد یک کارمند در حال استفاده از ChatGPT برای حل مشکلات مربوط به این درگاه بوده است.

کاربر در پیامی آمیخته با خشم و ناامیدی نوشته است: «این فوقالعاده وحشتناک و غیرقابلباور است که چطور این سیستم ضعیف طراحی شده و چطور موانعی بر سر راه بهبود آن قرار گرفتهاند. اگر اختیار با من بود، فقط برای این حماقت، [نام حذف شده سازنده نرمافزار] را اخراج میکردم. این کار اشتباه است.»

علاوه بر زبان صریح و گذرواژهها، گفتگوی لو رفته شامل نام اپلیکیشن مورد استفاده کارمند و شماره شعبهای است که مشکل در آن رخ داده است.

کل گفتگو بسیار فراتر از بخش حذفشده در تصویر بالا ادامه مییابد. لینکی که کاربر آرستکنیکا، چِیس وایتساید، در اختیار این نشریه قرار داده است، کل گفتگو را نشان میدهد. این URL جفتهای گذرواژه بیشتری را فاش میکند.

این نتایج در صبح روز دوشنبه، اندکی پس از استفاده وایتساید از ChatGPT برای یک پرسش بیارتباط، ظاهر شدند.

وایتساید در ایمیلی نوشت: «من برای یک پرسش (در این مورد، برای پیدا کردن نامهای خلاقانه برای رنگهای یک پالت) به سراغ ChatGPT رفتم و وقتی لحظاتی بعد برگشتم، متوجه گفتگوهای اضافی شدم. دیشب که از ChatGPT استفاده کردم (من یک کاربر پرکار هستم) آنجا نبودند. هیچ پرسشی انجام نشده بود – آنها فقط در تاریخچه من ظاهر شدند و مطمئناً از من نیستند (و فکر نمیکنم از کاربر مشابهی هم باشند).»

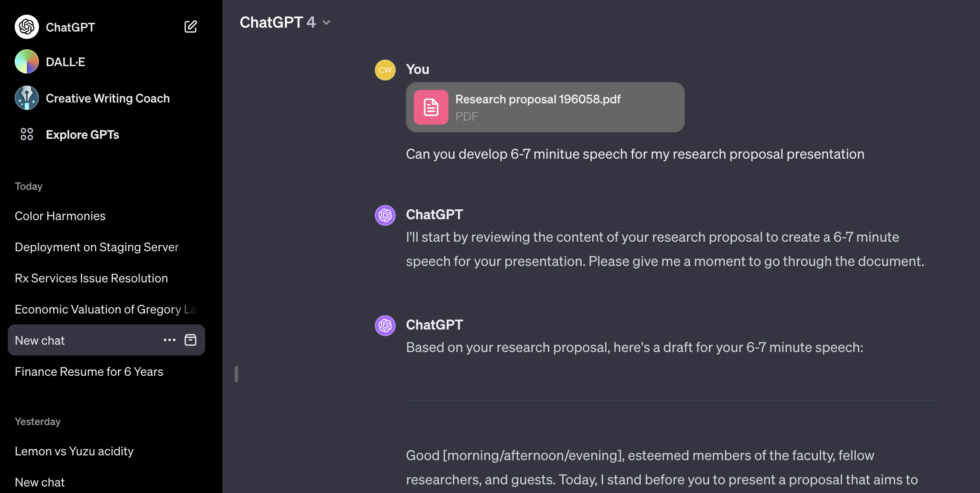

دیگر گفتگوهای درز کرده به وایتساید شامل نام یک ارائه که شخصی روی آن کار میکرد، جزئیات یک پروپوزال تحقیقاتی منتشر نشده و یک اسکریپت نوشتهشده با زبان برنامهنویسی PHP میشود. بهنظر میرسد کاربران هر گفتگوی لو رفته متفاوت و بیارتباط با یکدیگر باشند. گفتگوی مربوط به درگاه تجویز دارو، سال ۲۰۲۰ را ذکر میکند. تاریخ در گفتگوهای دیگر مشاهده نمیشود.

این اتفاق و موارد مشابه، اهمیت حذف اطلاعات شخصی از پرسشهای مطرحشده با ChatGPT و سایر سرویسهای هوش مصنوعی را به خوبی نشان میدهد. در ماه مارس گذشته، OpenAI، سازنده ChatGPT، پس از باگی که باعث نمایش عناوین گفتگوی یک کاربر فعال برای کاربران بیارتباط میشد، این چتبات را بهصورت موقت از دسترس خارج کرد.

در ماه نوامبر، پژوهشگرانی مقالهای منتشر کردند که نشان میداد آنها چگونه با پرسشهای خاص، ChatGPT را فریب دادهاند تا ایمیل، شماره تلفن و فکس، آدرسهای فیزیکی و سایر اطلاعات شخصی موجود در مواد مورد استفاده برای آموزش مدل زبان بزرگ ChatGPT را فاش کند.

نگرانی درباره احتمال درز اطلاعات مالکیتی یا خصوصی، باعث شده است شرکتهایی مانند اپل، استفاده کارمندان خود از ChatGPT و سایتهای مشابه را محدود کنند.